Em março de 2025, uma empresa brasileira de médio porte enfrentou um pesadelo: dados confidenciais de 15 mil clientes apareceram em resultados de busca do Google. A causa? Um analista havia colado relatórios completos no ChatGPT gratuito para "resumir rapidamente". O prejuízo: R$ 2,3 milhões em multas LGPD, processos judiciais e danos à reputação. Esse caso não é fictício — e está se tornando assustadoramente comum.

Enquanto 78% das empresas brasileiras aceleram a adoção de IA em 2025, a maioria ainda usa ferramentas gratuitas sem nenhum controle de segurança. O resultado? Uma bomba-relógio de compliance prestes a explodir.

O cenário atual: a tempestade perfeita de risco e oportunidade

Seus dados empresariais são, simultaneamente, seu maior ativo estratégico e sua vulnerabilidade mais crítica. Em 2025, vivemos uma contradição perigosa:

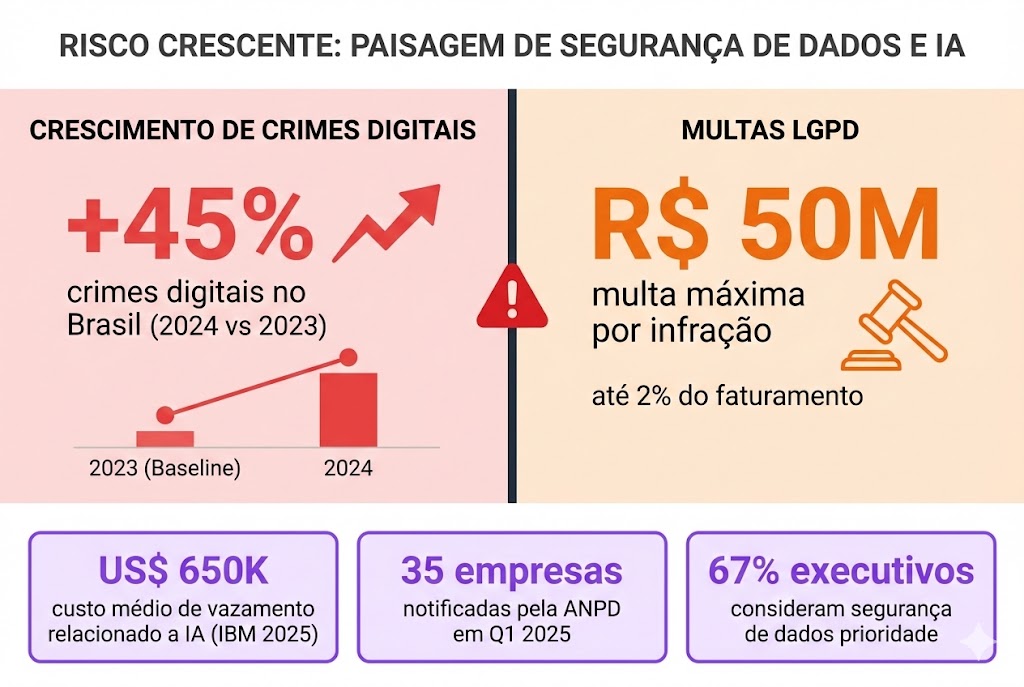

De um lado: A ANPD intensificou fiscalizações, notificando mais de 35 empresas nos primeiros três meses do ano. As multas não são mais ameaças abstratas — chegam a R$ 50 milhões por infração, com casos reais de empresas pagando valores de sete dígitos.

Do outro: Funcionários de todos os setores copiam e colam dados confidenciais em ChatGPT, Claude, Gemini e dezenas de outras ferramentas gratuitas, sem qualquer controle ou visibilidade corporativa.

Segundo o relatório IBM Cost of a Data Breach 2025, vazamentos associados ao uso inadequado de IA custam às organizações uma média de US$ 650 mil por incidente. Isso sem contar:

- Perda de confiança de clientes e parceiros

- Paralisação operacional durante investigações

- Custos legais com ações de titulares de dados

- Danos permanentes à reputação da marca

67% dos executivos brasileiros consideram os riscos de cibersegurança e proteção de dados como a principal prioridade de compliance em 2025 — mas apenas 23% implementaram governança específica para uso de IA.

A questão não é mais "se" sua empresa usará IA, mas como você protegerá seus dados ao fazê-lo. E o relógio está correndo.

Os 5 riscos invisíveis que estão vazando seus dados agora mesmo

1. Treinamento de modelos: o risco que ninguém lê nos termos de uso

Este é o perigo menos compreendido e potencialmente mais devastador. Aqui está a verdade inconveniente que surpreende até gestores experientes:

Mesmo ferramentas pagas podem usar seus dados para treinar modelos de IA — e a maioria dos usuários não sabe disso porque não leu (ou não entendeu) os termos de serviço.

Veja como as principais plataformas realmente funcionam:

ChatGPT (OpenAI):

- Versão Gratuita: Usa suas conversas para treinar modelos futuros por padrão. Você pode desabilitar em Settings > Data Controls, mas precisa fazer isso manualmente.

- ChatGPT Plus ($20/mês): Mesma política da versão gratuita. Muitos usuários pagantes assumem que estão protegidos — estão errados.

- ChatGPT Team ($25/usuário): Opt-out por padrão, mas requer configuração correta do workspace.

- ChatGPT Enterprise: Não usa dados para treinamento. Você precisa explicitamente optar por compartilhar (opt-in).

Outras plataformas populares:

- Meta (WhatsApp Business, Instagram): Desde maio de 2024, usa postagens públicas e interações para treinar o Meta AI. Sem opt-out real.

- X/Twitter: Coleta dados de usuários para treinar o Grok. Sem opção de desativação.

- WeTransfer: Anunciou que usará materiais enviados para treinar modelos de IA generativa.

- Google Gemini: Versões gratuitas e pagas mantêm dados para melhorias, com políticas variáveis por região.

Cenário real que aconteceu em fevereiro de 2025:

Um CFO de uma empresa de tecnologia brasileira colou o relatório financeiro trimestral completo (incluindo projeções estratégicas confidenciais) no ChatGPT Plus para gerar uma apresentação para investidores. Ele assumiu que, por pagar $20/mês, seus dados estavam seguros.

Três semanas depois, um concorrente fez uma pergunta genérica ao ChatGPT sobre "estratégias de precificação no setor de SaaS B2B" e recebeu uma resposta suspeitosamente similar às projeções confidenciais da empresa. Coincidência? Improvável.

O problema: A configuração de opt-out não é ativada automaticamente ao pagar. Quantos colaboradores da sua empresa sabem verificar isso?

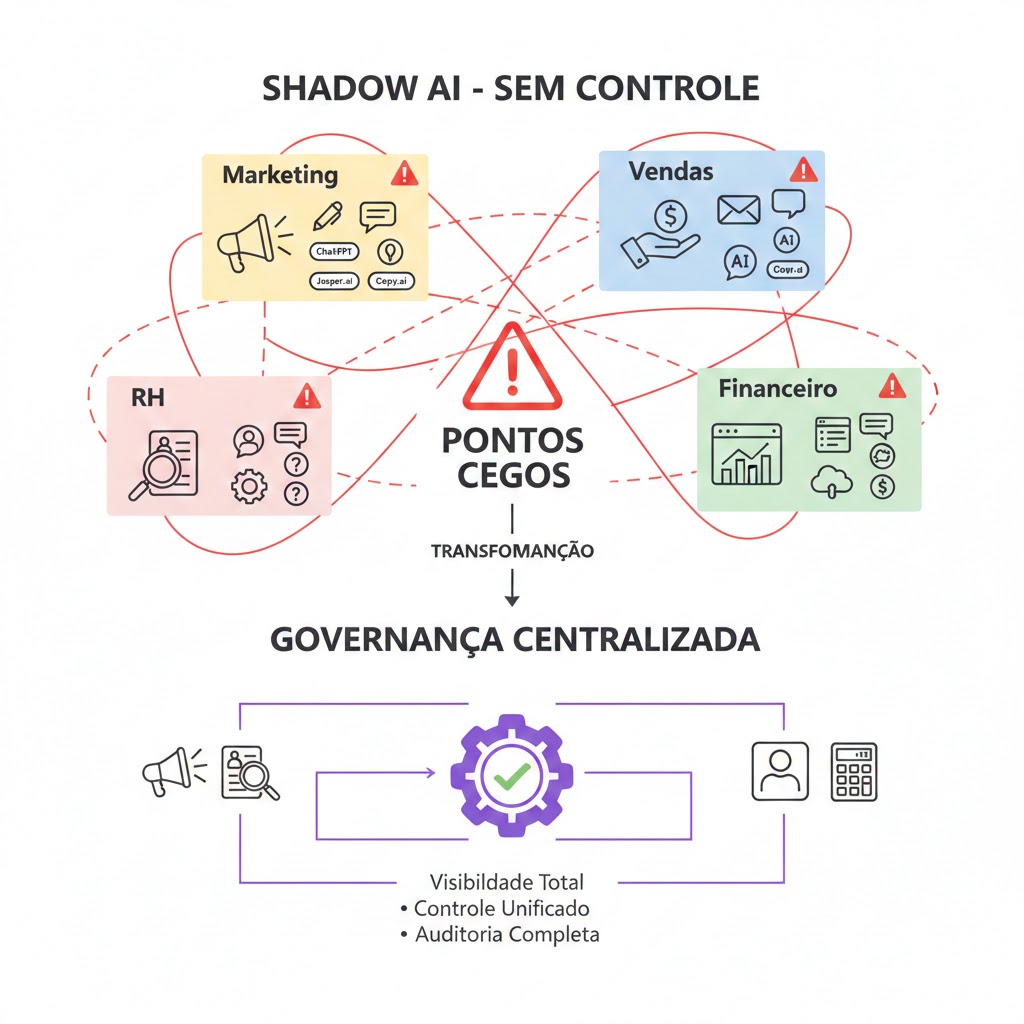

2. Shadow AI: o problema que TI não vê

Shadow IT sempre foi um desafio. Shadow AI é uma crise exponencialmente maior.

Enquanto sua equipe de TI controla quais softwares são aprovados, colaboradores criam contas pessoais em dezenas de ferramentas de IA sem qualquer supervisão:

- Marketing usa Jasper, Copy.ai, ChatGPT

- Vendas usa ferramentas de geração de emails com IA

- RH usa sistemas de triagem de currículos com IA

- Financeiro usa planilhas "inteligentes" em nuvem

- Atendimento experimenta chatbots gratuitos

Cada uma dessas ferramentas é um ponto potencial de vazamento. Sem visibilidade centralizada, você não consegue:

- Saber quais dados estão sendo compartilhados

- Implementar políticas de uso consistentes

- Auditar atividades para compliance

- Responder rapidamente a incidentes

3. O erro humano bem-intencionado

A maioria dos vazamentos de dados relacionados à IA não vem de hackers sofisticados ou ataques externos. Vem de funcionários competentes tentando fazer seu trabalho de forma mais eficiente.

Exemplos cotidianos que acontecem agora mesmo na sua empresa:

- Analista cola lista de clientes com CPFs para "organizar em formato de relatório"

- Designer envia briefings confidenciais de clientes para ferramentas de geração de imagens

- Desenvolvedor compartilha código proprietário para "debugar mais rápido"

- Coordenador de RH processa dados pessoais de candidatos em ferramentas externas

Nenhum desses profissionais é malicioso. Eles estão apenas buscando produtividade. Mas sem políticas claras, treinamento adequado e controles técnicos, a conveniência sempre vencerá a segurança.

4. Ausência total de auditoria e rastreabilidade

Imagine que amanhã a ANPD bate à sua porta solicitando um relatório completo sobre como sua empresa usa IA e trata dados pessoais. Você consegue responder com confiança:

- Quem acessou quais dados nos últimos 90 dias?

- Quais informações foram compartilhadas com sistemas de IA externos?

- Que decisões automatizadas foram tomadas e com que base?

- Como os dados foram protegidos em cada etapa do processamento?

- Há registros completos e imutáveis de todas essas atividades?

Se você usa ferramentas gratuitas ou mesmo pagas sem capacidades enterprise, a resposta honesta é: "Não temos como saber".

E essa resposta pode custar milhões em multas e processos.

5. Falta de controle sobre localização e armazenamento de dados

Quando você ou sua equipe usam uma ferramenta de IA na nuvem, onde exatamente esses dados são processados e armazenados?

- Em quais países?

- Por quanto tempo?

- Quem mais tem acesso?

- Sob quais jurisdições legais?

- Com que padrões de criptografia?

Para empresas que precisam cumprir a LGPD (especialmente Artigo 33 sobre transferência internacional), essas não são questões filosóficas — são requisitos legais obrigatórios.

A maioria das ferramentas gratuitas e até pagas não oferece:

- Garantias contratuais sobre localização de dados

- Opção de processamento exclusivamente em território brasileiro

- Segregação lógica ou física de dados por cliente

- Controles de residência de dados auditáveis

Frameworks de governança: da teoria regulatória à prática corporativa

Governança de IA é o conjunto estruturado de princípios, políticas, processos e controles técnicos que garantem que sistemas de inteligência artificial sejam éticos, seguros, transparentes e conformes com regulamentações aplicáveis.

Não é apenas documentação — é infraestrutura, cultura organizacional e responsabilidade.

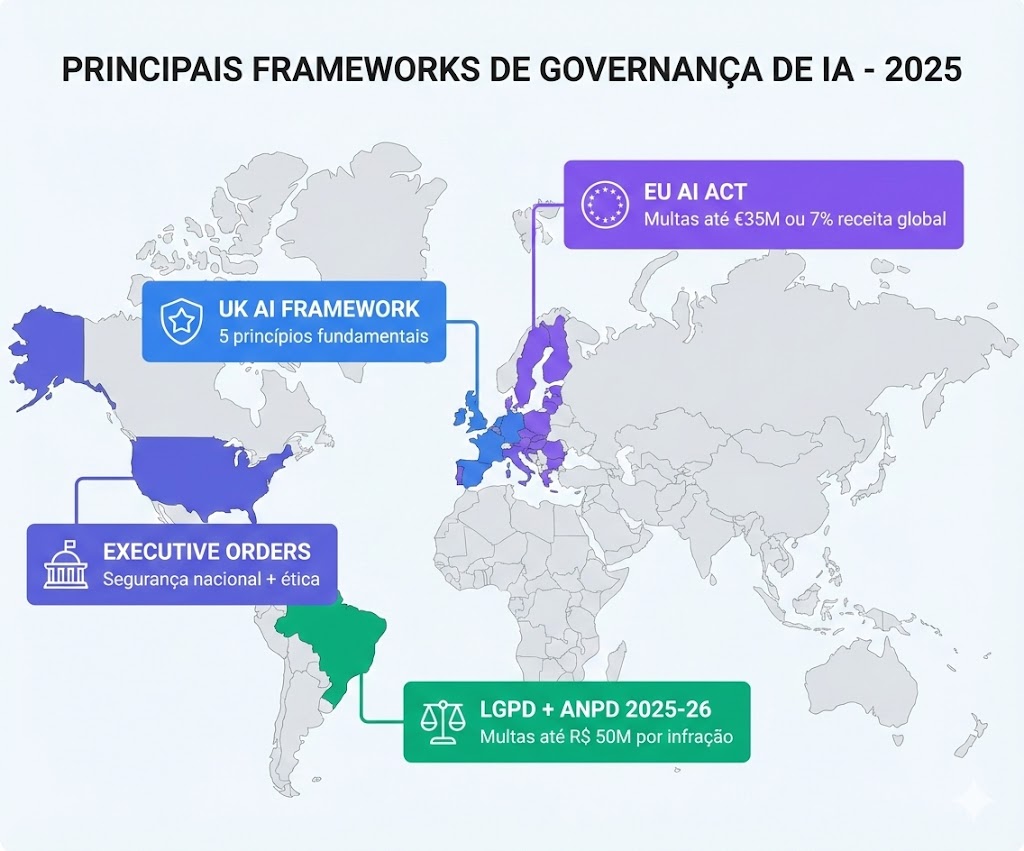

Principais frameworks globais que você precisa conhecer

Governos ao redor do mundo estão estabelecendo diretrizes cada vez mais rigorosas:

EU AI Act (União Europeia) — Em vigor desde 2024:

- Bane usos específicos de IA (como pontuação social estilo China)

- Classifica sistemas de IA em categorias de risco (mínimo, limitado, alto, inaceitável)

- Impõe controles rigorosos para aplicações de alto risco: saúde, finanças, infraestrutura crítica, RH

- Multas de até €35 milhões ou 7% da receita global anual

UK AI Framework — 5 princípios fundamentais:

- Segurança e robustez: Sistemas devem funcionar de forma confiável

- Transparência: Clareza sobre quando e como IA é usada

- Equidade: Prevenção de viés e discriminação

- Responsabilização: Alguém deve ser responsável pelas decisões da IA

- Contestabilidade: Pessoas devem poder desafiar decisões automatizadas

Executive Orders dos EUA: Orientações federais focadas em uso ético, segurança nacional e proteção de dados sensíveis.

LGPD e Agenda ANPD 2025-2026 (Brasil):

A ANPD está desenvolvendo regulamentações específicas sobre:

- Uso de IA em decisões automatizadas (Artigo 20 da LGPD)

- Tratamento de dados biométricos e sensíveis

- Processamento de dados por órgãos públicos

- Viés algorítmico, discriminação e transparência

Os 4 pilares essenciais de governança de IA empresarial

Independentemente do framework escolhido, uma governança eficaz de IA corporativa deve incluir:

1. Políticas Claras e Documentadas de Uso

Não basta ter uma política genérica de TI. Você precisa de diretrizes específicas sobre IA que respondam:

- Quais ferramentas de IA são aprovadas para uso corporativo?

- Que tipos de dados podem (e não podem) ser compartilhados?

- Quais são as consequências do descumprimento?

- Como solicitar aprovação para novas ferramentas?

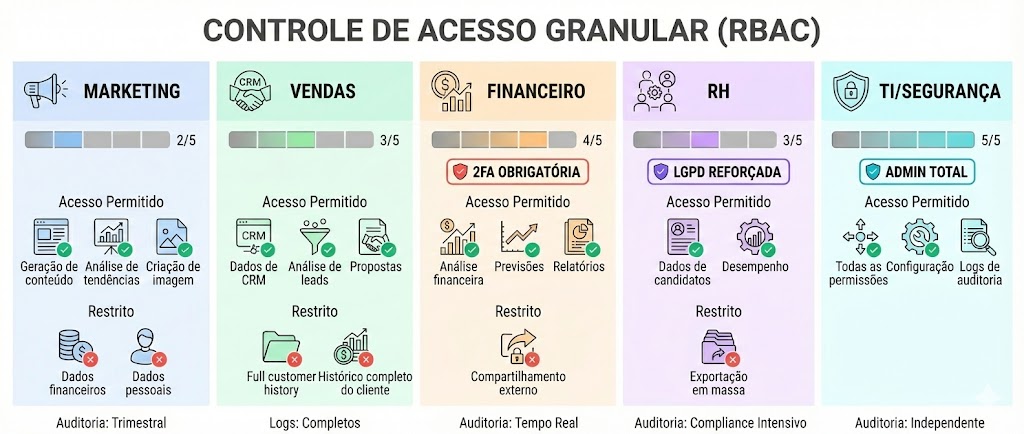

2. Controle de Acesso Granular (RBAC)

Nem todos precisam acessar tudo. Implemente Role-Based Access Control que reflita responsabilidades reais:

- Marketing: Acesso a ferramentas de conteúdo, sem dados financeiros

- Financeiro: Permissões restritas com auditoria reforçada

- RH: Acesso limitado a dados pessoais, com logs completos

- Liderança: Visibilidade ampla com autenticação multifator obrigatória

3. Monitoramento Contínuo e Alertas Inteligentes

Segurança não é "configurar e esquecer". Você precisa de vigilância em tempo real:

- Detecção de compartilhamento de informações sensíveis (CPF, CNPJ, dados financeiros)

- Alertas automáticos para comportamentos anômalos

- Bloqueio preventivo de ações de alto risco

- Dashboard executivo com visibilidade total

4. Auditoria Completa e Imutável

Para compliance LGPD e resposta a incidentes, você precisa de registros detalhados e à prova de manipulação:

- Quem acessou o quê, quando e de onde

- Que prompts foram enviados a sistemas de IA

- Quais decisões automatizadas foram tomadas

- Trilha completa de modificações e aprovações

Plataformas corporativas como a Quintus já incorporam esses controles por design, eliminando a necessidade de configurações complexas e reduzindo drasticamente o risco de erro humano.

Controle de acesso por departamento: o princípio do menor privilégio

O Princípio do Menor Privilégio (Principle of Least Privilege) é uma das práticas mais eficazes de segurança: cada usuário deve ter acesso apenas aos recursos estritamente necessários para realizar seu trabalho.

Aplicado à IA corporativa, isso significa arquitetura de permissões que reflete a realidade operacional da empresa.

Exemplo prático: estrutura de permissões por departamento

| Departamento | Acesso Permitido | Restrições | Monitoramento |

|---|---|---|---|

| Marketing | Geração de conteúdo, análise de tendências, criação de imagens | Sem acesso a dados financeiros ou informações pessoais de clientes | Auditoria trimestral |

| Vendas | Análise de leads, geração de propostas, insights de CRM | Dados de clientes específicos do pipeline, sem acesso a histórico completo | Logs completos de consultas |

| Financeiro | Análise de dados financeiros, previsões, relatórios | Acesso restrito com autenticação dupla, sem compartilhamento externo | Auditoria contínua, alertas em tempo real |

| RH | Processamento de candidatos, análise de desempenho | Dados pessoais requerem justificativa por consulta, retenção limitada | Compliance LGPD intensificado |

| TI/Segurança | Permissões administrativas, configuração de políticas | Dupla autenticação obrigatória, alertas automáticos para ações críticas | Auditoria independente |

Como combater Shadow AI com governança centralizada

Shadow AI só prospera onde há falta de alternativas aprovadas e convenientes.

A solução não é proibir o uso de IA (isso é ineficaz e frustra equipes), mas sim oferecer ferramentas corporativas que sejam tão ou mais convenientes que as gratuitas, com segurança embutida.

Estratégia em 3 passos:

- Mapeamento: Conduza auditoria completa identificando todas as ferramentas em uso (oficiais e shadow IT)

- Consolidação: Implemente plataforma enterprise que atenda às necessidades reais dos departamentos

- Educação: Treine colaboradores sobre por que a ferramenta corporativa é mais segura e vantajosa

Empresas que consolidam o uso de IA em plataformas enterprise com governança centralizada experimentam 76% menos incidentes de exposição de dados em comparação com aquelas que permitem uso descentralizado de ferramentas gratuitas.

Compliance LGPD: o que você precisa saber agora

A Lei Geral de Proteção de Dados não é negociável, e em 2025 a fiscalização está mais rigorosa do que nunca.

Obrigações imediatas que você não pode ignorar

1. Notificação de Incidentes (Resolução CD/ANPD nº 15/2024):

Se sua empresa sofrer um vazamento de dados envolvendo sistemas de IA, você tem até 3 dias úteis após tomar conhecimento do incidente para:

- Comunicar a ANPD formalmente

- Notificar os titulares de dados afetados (se houver risco relevante)

- Detalhar medidas técnicas tomadas para mitigar o dano

Não cumprimento: Multas adicionais por ocultação.

2. Documentação de Tratamento (Artigo 37 da LGPD):

Você deve manter registros detalhados de:

- Como a IA processa dados pessoais

- Qual a base legal para esse processamento (consentimento, legítimo interesse, etc.)

- Quais medidas de segurança foram implementadas

- Quando e como os dados serão eliminados

3. Direitos dos Titulares (Artigos 17-22 da LGPD):

Usuários têm direito de:

- Saber se suas informações são usadas em sistemas de IA

- Solicitar explicação sobre decisões automatizadas

- Contestar decisões tomadas exclusivamente por IA

- Requerer correção, anonimização ou exclusão de dados

Se você não consegue responder rapidamente a essas solicitações, está em violação.

Agenda regulatória ANPD 2025-2026: o que vem por aí

A ANPD está desenvolvendo regulamentações específicas sobre:

- Decisões automatizadas (Artigo 20): Transparência sobre quando IA toma decisões que afetam pessoas

- Dados biométricos: Controles especiais para reconhecimento facial, voz, impressões digitais

- Viés algorítmico: Prevenção de discriminação em sistemas de IA (crédito, RH, seguros)

- IA em órgãos públicos: Regras específicas para uso governamental

Empresas que aguardam regulamentação finalizada para agir estão assumindo riscos desnecessários. As melhores práticas já estão claras — implemente-as agora.

Multas e sanções: o custo real do descumprimento

As penalidades previstas pela LGPD incluem (Artigo 52):

- Advertência com prazo para adoção de medidas corretivas

- Publicação da infração (dano reputacional massivo)

- Multas simples: Até 2% do faturamento da empresa no Brasil (limitadas a R$ 50 milhões por infração)

- Multas diárias

- Bloqueio ou eliminação de dados pessoais relacionados à infração

- Suspensão parcial ou total das atividades de tratamento de dados

Exemplo real: Em 2024, uma grande empresa de telecomunicações brasileira foi multada em R$ 9,6 milhões por falhas no tratamento de dados. Com a adição de IA ao mix, os riscos só aumentam.

Práticas recomendadas: sua checklist acionável de governança

Implementar governança de IA pode parecer intimidador, mas seguir um roteiro estruturado torna o processo gerenciável e mensurável.

Checklist completa de implementação

Fase 1: Diagnóstico (Semana 1-2)

- Mapear todas as ferramentas de IA em uso na empresa (incluindo shadow IT)

- Identificar quem está usando o quê e para quais finalidades

- Avaliar quais dados estão sendo processados por cada ferramenta

- Documentar riscos identificados e classificar por severidade

Fase 2: Políticas e Processos (Semana 2-4)

- Criar política clara de uso de IA corporativa: o que é permitido, o que é proibido, quais ferramentas são aprovadas, processo de aprovação para novas ferramentas, consequências do descumprimento

- Tornar a política acessível, clara e compreensível

- Obter aprovação de Jurídico e LGPD

Fase 3: Controles Técnicos (Semana 4-8)

- Implementar RBAC (Role-Based Access Control) por departamento

- Configurar alertas automáticos para dados sensíveis (CPF, CNPJ, dados financeiros)

- Escolher e implantar plataforma enterprise com DLP e auditoria built-in

- Migrar gradualmente de ferramentas gratuitas para solução corporativa

Fase 4: Educação e Cultura (Contínuo)

- Realizar treinamento inicial para todos os colaboradores sobre: riscos do uso inadequado de IA, boas práticas de proteção de dados, como usar ferramentas aprovadas, a quem reportar incidentes

- Agendar treinamentos trimestrais de atualização

- Criar canal de comunicação para dúvidas sobre uso de IA

Fase 5: Monitoramento e Melhoria (Contínuo)

- Realizar auditorias trimestrais de logs e permissões

- Revisar alertas e incidentes mensalmente

- Atualizar políticas conforme novas regulamentações surgem

- Documentar tudo para demonstrar compliance LGPD

Comparando soluções: o custo real de cada abordagem

Entender as diferenças práticas entre tipos de ferramentas de IA é essencial para tomar decisões informadas que equilibrem produtividade, segurança e compliance.

| Recurso | Ferramentas Gratuitas | Pagas (Plus/Pro) | Enterprise/Privadas |

|---|---|---|---|

| Uso de dados para treino | Sim (padrão, difícil desabilitar) | Depende (opt-out manual)* | Não (by design)** |

| Controle de acesso | Inexistente (contas pessoais) | Individual (sem gestão centralizada) | Granular/RBAC por departamento |

| Auditoria e logs | Não disponível | Limitada (apenas histórico pessoal) | Completa (todos os usuários, imutável) |

| Compliance LGPD | Não (sem garantias contratuais) | Parcial (depende de configuração) | Built-in (DLP, residência de dados, DPA) |

| Dados no Brasil | Não (servidores globais) | Não (servidores globais) | Sim (opcional, controlável) |

| Suporte | Comunidade (sem SLA) | Email (resposta em dias) | Dedicado (SLA contratual) |

| DLP (Data Loss Prevention) | Não existe | Não existe | Sim (detecção automática de dados sensíveis) |

| SSO/Integração AD | Não | Não | Sim (integração com infraestrutura corporativa) |

| Custo mensal | R$ 0 | R$ 100-300/usuário | R$ 500-2000/usuário |

| Custo real (incluindo risco) | R$ 50 milhões (multa potencial LGPD) | R$ 10-50 milhões (risco moderado) | R$ 500-2000/usuário (risco controlado) |

* ChatGPT Plus e ferramentas pagas similares usam dados por padrão, mas permitem opt-out manual. Estudos mostram que menos de 15% dos usuários pagantes desabilitam isso.

** Plataformas como Quintus nunca usam dados de clientes para treinamento de modelos, sem exceções ou possibilidade de opt-in.

Organizações com implementações privadas de IA experimentam 76% menos incidentes de exposição de dados e resolvem incidentes 4,2 vezes mais rápido em comparação com aquelas que dependem exclusivamente de serviços públicos.

Case: como uma empresa de logística evitou um desastre (Caso hipotético)

Cenário: Empresa brasileira de logística com 800 funcionários, processando dados de 50 mil clientes mensalmente.

Problema identificado: Em auditoria interna de março de 2025, a equipe de TI descobriu que 67% dos colaboradores usavam ChatGPT gratuito para tarefas do dia a dia. Analistas colavam listas completas de clientes com dados pessoais para "organizar relatórios". Nenhum controle ou visibilidade sobre que informações eram compartilhadas. Risco imenso de vazamento e multa LGPD.

Solução implementada em 45 dias:

- Bloqueio preventivo: Ferramentas de IA gratuitas foram bloqueadas na rede corporativa

- Alternativa corporativa: Implantação de plataforma enterprise (Quintus) com controles de acesso por departamento, DLP automático detectando CPFs e CNPJs, auditoria completa de todas as interações, dados processados exclusivamente no Brasil

- Educação: Treinamento obrigatório para 100% dos colaboradores sobre uso seguro de IA

- Políticas claras: Documentação acessível sobre o que é permitido e proibido

Resultados após 3 meses:

- Zero incidentes de vazamento de dados relacionados a IA

- 94% de adoção da plataforma corporativa (colaboradores preferem pela conveniência)

- Compliance LGPD completo, com registros auditáveis para demonstração à ANPD

- ROI positivo: Produtividade aumentou 28% com IA segura, sem riscos

Custo evitado: Potencial multa de até R$ 12 milhões (estimativa baseada em faturamento e gravidade de possível vazamento)

Como a Quintus oferece governança de IA by design

Diferentemente de ferramentas genéricas de IA que adicionam controles de segurança como "recursos extras", a Quintus foi projetada desde o início com governança corporativa embutida.

Principais diferenciais de segurança e compliance

1. Dados nunca usados para treinamento

Seus dados corporativos permanecem exclusivamente seus. Não há opt-out porque não há opt-in. Simples assim.

2. Controle granular de acesso

Defina permissões por departamento, equipe ou usuário individual. Marketing não vê dados financeiros. RH tem auditoria reforçada. TI tem visibilidade total.

3. DLP (Data Loss Prevention) inteligente

A plataforma detecta automaticamente quando um usuário tenta compartilhar CPFs e CNPJs, dados financeiros (cartões, contas bancárias), informações confidenciais marcadas, ou documentos com classificação restrita. E bloqueia ou alerta conforme configuração.

4. Auditoria completa e imutável

Registros detalhados de todas as interações: quem acessou o quê, quando e de onde; quais prompts foram enviados; que respostas foram geradas; logs à prova de manipulação para compliance.

5. Residência de dados controlável

Opção de processar e armazenar dados exclusivamente em território brasileiro, cumprindo requisitos LGPD para empresas reguladas.

6. Integração nativa com sistemas corporativos

Conecta-se diretamente a ERP, CRM, sistemas de tickets e bases de conhecimento — sem necessidade de copiar e colar dados manualmente (eliminando o principal vetor de vazamento).

Saiba mais sobre como a Quintus pode proteger seus dados enquanto impulsiona produtividade em nossa página de plataforma.

Conclusão: governança não é opcional — é estratégia de sobrevivência

A era de usar IA de forma improvisada, sem controles e "na esperança de que dê certo" acabou.

Em 2025, governança de IA não é um diferencial competitivo, um checkbox de compliance ou um "seria bom ter". É uma necessidade regulatória absoluta e uma decisão estratégica crítica para a sobrevivência da empresa.

Os riscos estão claros e quantificados:

- Vazamentos de dados custando US$ 650 mil+ por incidente

- Multas LGPD de até R$ 50 milhões por infração

- Danos reputacionais que destroem confiança construída ao longo de décadas

- Paralisações operacionais que comprometem receita

Mas a boa notícia é que as soluções também estão disponíveis, acessíveis e comprovadamente eficazes. Com as ferramentas, processos e cultura certos, sua empresa pode:

- Usar IA de forma segura, produtiva e conforme

- Demonstrar compliance total à ANPD com registros auditáveis

- Proteger dados de clientes, parceiros e colaboradores

- Construir vantagem competitiva baseada em confiança e transparência

Empresas que implementam governança adequada de IA não estão apenas evitando problemas — estão construindo uma vantagem competitiva sustentável em um mercado onde confiança, transparência e excelência operacional se tornaram diferenciais decisivos.

A pergunta não é mais "se" você implementará governança de IA, mas "quando" — e quanto mais cedo começar, mais protegida e competitiva sua empresa estará.

Quer discutir como implementar governança de IA na sua empresa? Entre em contato com nossa equipe para uma consultoria personalizada.